A artista Stephanie Dinkins é pioneira, há muito tempo, na combinação entre arte e tecnologia em seu escritório no Brooklyn. Em maio, ela recebeu US$ 100 mil do Museu Guggenheim por suas inovações revolucionárias, incluindo uma série contínua de entrevistas com Bina48, um robô humanoide.

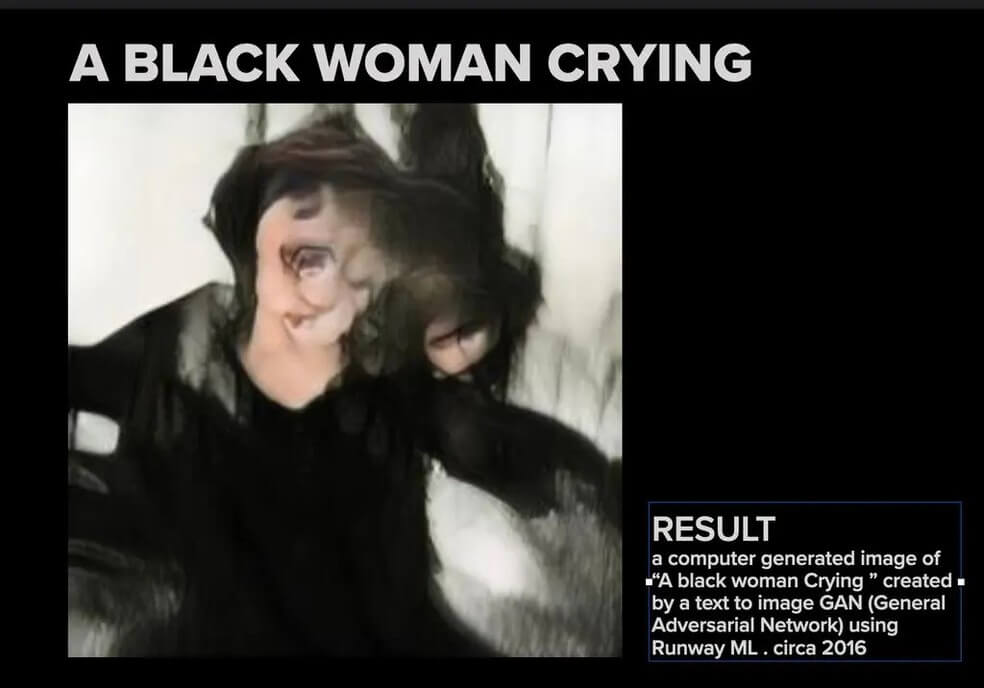

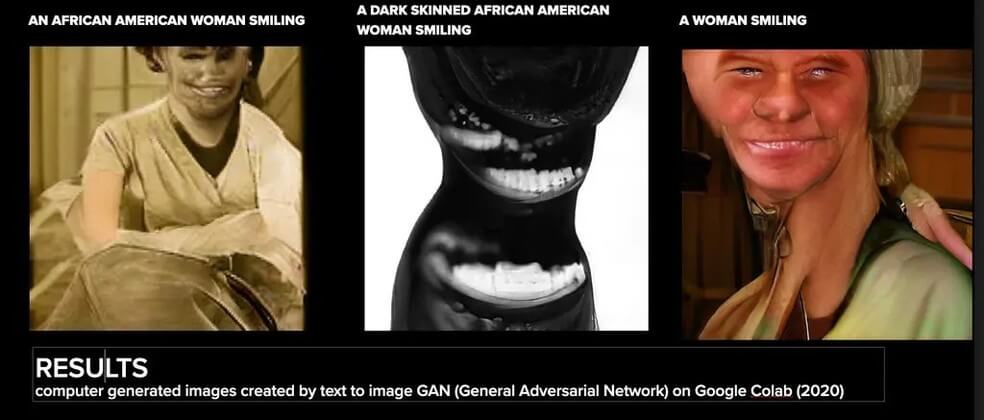

Nos últimos sete anos, ela experimentou a capacidade da inteligência artificial de retratar realisticamente mulheres negras, sorrindo e chorando, usando uma variedade de comandos de palavras. Os primeiros resultados foram medíocres, se não alarmantes: o algoritmo produziu um humanoide rosa envolto por um manto preto.

“Eu esperava algo com um pouco mais de semelhança com a feminilidade negra”, afirmou. E, embora a tecnologia tenha melhorado desde seus primeiros experimentos, Dinkins se viu empregando termos indiretos nos prompts de texto para auxiliar os geradores de IA a alcançar a imagem desejada, “para dar à máquina a chance de me dar o que eu queria”. Mas, quer ela use o termo “mulher afro-americana” ou “mulher negra”, as distorções da máquina continuam, expressivamente, mutilando as características faciais e as texturas do cabelo.

“As melhorias ocultam algumas das questões mais profundas que devemos levantar a respeito da discriminação”, disse Dinkins. A artista, que é negra, acrescentou: “Os preconceitos estão profundamente enraizados nesses sistemas, tornando-se arraigados e automáticos. Se estou trabalhando em um sistema que usa ecossistemas algorítmicos, quero que esse sistema saiba quem são os negros de diversas maneiras, para que possamos nos sentir verdadeiramente apoiados.

Ela não está sozinha em fazer perguntas difíceis sobre a relação problemática entre IA e raça. Muitos artistas negros estão encontrando evidências de preconceito racial na IA, tanto nos grandes conjuntos de dados que ensinam as máquinas a gerar imagens, quanto nos programas subjacentes que executam os algoritmos. Em alguns casos, as tecnologias de IA parecem ignorar ou distorcer as solicitações de texto dos artistas, afetando a maneira como os negros são retratados nas imagens e, em outros, parecem estereotipar ou censurar a história e a cultura negras.

A discussão sobre o viés racial na IA aumentou nos últimos anos, com estudos mostrando que as tecnologias de reconhecimento facial e os assistentes digitais têm problemas para identificar as imagens e os padrões de fala de pessoas não brancas. Os estudos levantaram questões mais amplas de justiça e viés.

As principais empresas por trás da geração de imagens por I.A. – incluindo OpenAI, Stability AI e Midjourney – prometeram melhorar suas ferramentas. “O viés é um problema importante em todo o setor”, disse Alex Beck, porta-voz da OpenAI, em uma entrevista por e-mail ao The New York Times, acrescentando que a empresa está continuamente tentando “melhorar o desempenho, reduzir o viés e mitigar resultados prejudiciais”. Ela se recusou a dizer quantos funcionários estavam trabalhando com a questão do preconceito racial ou quanto de verba a empresa havia alocado para o problema.

“Os negros estão acostumados a não serem vistos”, escreveu a artista senegalesa Linda Dounia Rebeiz na introdução de sua exposição “In/Visible”, para Feral File, um mercado NFT. “Quando somos vistos, estamos acostumados a ser deturpados.”

Para provar seu ponto durante uma entrevista com um repórter, Rebeiz, 28 anos, pediu ao gerador de imagens da OpenAI, DALL-E 2, para imaginar edifícios em sua cidade natal, Dakar. O algoritmo produziu paisagens desérticas áridas e edifícios em ruínas que Rebeiz disse não serem nada parecidos com as casas costeiras da capital senegalesa.

“É desmoralizante”, disse Rebeiz. “O algoritmo se inclina para uma imagem cultural da África que o Ocidente criou. O padrão são os piores estereótipos que já existem na internet.”

No ano passado, a OpenAI afirmou estar estabelecendo novas técnicas para diversificar as imagens produzidas pelo DALL-E 2, para que a ferramenta “gerasse imagens de pessoas que refletissem com mais precisão a diversidade da população mundial”.

Artista que participa da exposição de Rebeiz, Minne Atairu é candidata a Ph.D. na escola para professores da Universidade de Columbia, que planejava usar geradores de imagens com jovens estudantes negros no sul do Bronx. Mas, atualmente, ela tem a preocupação de “que isso possa levar os alunos a gerar imagens ofensivas”, explicou Atairu.

Incluídas na exposição Feral File, estão imagens de seus “Blonde Braids Studies” (estudos sobre tranças loiras, em tradução livre), que exploram as limitações do algoritmo de Midjourney para produzir imagens de mulheres negras com cabelos loiros naturais. Quando a artista pediu imagem de gêmeos idênticos negros com cabelos loiros, o programa produziu um dos irmãos com a pele mais clara.

“Isso nos diz de onde o algoritmo está reunindo imagens”, disse Atairu. “Não é necessariamente retirado do corpo de negros, mas é voltado para os brancos.”

Ela afirma que temia que crianças negras tentassem gerar imagens de si mesmas e ver crianças cuja pele foi clareada. Atairu relembrou alguns de seus experimentos com Midjourney antes de atualizações recentes melhorarem suas habilidades. “Iria gerar imagens que eram como blackface”, disse ela. “Você veria um nariz, mas não era o nariz de um humano. Parecia o nariz de um cachorro.”

Em resposta a um pedido de pronunciamento, David Holz, fundador da Midjourney, disse, por e-mail: “Se alguém encontrar um problema com nossos sistemas, pedimos que nos envie exemplos específicos para podermos investigar”.

A Stability AI, que fornece serviços de geração de imagens, disse que planeja colaborar com a indústria de IA para melhorar as técnicas de avaliação de viés com maior diversidade de países e culturas. O viés, disse a empresa de IA, é causado pela “super-representação” em seus conjuntos de dados gerais, embora não tenha especificado se a super-representação de pessoas brancas era o problema aqui.

No início deste mês, a Bloomberg analisou mais de 5 mil imagens geradas pela Stability AI e descobriu que seu programa ampliava os estereótipos sobre raça e gênero, geralmente retratando pessoas com tons de pele mais claros como tendo empregos bem remunerados, enquanto indivíduos com tons de pele mais escuros eram rotulados como “lava-louças” e “governanta”.

Esses problemas não impediram um frenesi de investimentos na indústria de tecnologia. Um relatório otimista recente da empresa de consultoria McKinsey previu que a IA generativa adicionaria US$ 4,4 trilhões à economia global anualmente. No ano passado, cerca de 3.200 startups receberam US$ 52,1 bilhões em financiamento, segundo o GlobalData Deals Database.

As empresas de tecnologia têm lutado contra as acusações de preconceito nas representações de pele escura desde o surgimento da fotografia colorida na década de 1950, quando empresas como a Kodak usavam modelos brancos em seu desenvolvimento de cores. Oito anos atrás, o Google desativou a capacidade de seu programa de IA de permitir que as pessoas pesquisassem gorilas e macacos por meio de seu aplicativo Fotos porque o algoritmo classificava, incorretamente, negros nessas categorias. Até maio deste ano, o problema ainda não havia sido resolvido. Dois ex-funcionários que trabalharam na tecnologia disseram ao The New York Times que o Google não havia treinado o sistema de IA com imagens suficientes de pessoas negras.

Especialistas que estudam inteligência artificial afirmaram que o viés é mais profundo do que conjuntos de dados, referindo-se ao desenvolvimento inicial dessa tecnologia na década de 1960.

“A questão é mais complicada do que o viés de dados”, disse James E. Dobson, historiador cultural da Universidade Dartmouth e autor de um livro recente sobre o nascimento da visão computacional. Havia muito pouca discussão sobre raça durante os primeiros momentos da inteligência das máquinas, de acordo com sua pesquisa, e a maioria dos cientistas que trabalhavam na tecnologia eram homens brancos.

“É difícil separar os algoritmos de hoje dessa história, porque os engenheiros estão desenvolvendo essas versões anteriores”, afirma Dobson.

Para diminuir a aparência de preconceito racial e imagens de ódio, algumas empresas baniram certas palavras dos prompts de texto que os usuários enviam aos geradores, como “escravo” e “fascista”.

Mas Dobson disse que as empresas que esperavam por uma solução simples, como censurar o tipo de solicitação que os usuários podem enviar, estavam evitando os problemas mais fundamentais de viés na tecnologia subjacente.

“É um momento preocupante, pois esses algoritmos se tornam mais complicados. E quando você vê o lixo saindo, você deve se perguntar que tipo de processo de lixo ainda está dentro do sistema”, acrescentou o professor.

Auriea Harvey, uma artista incluída na recente exposição “Refiguring” do Museu Whitney, sobre identidades digitais, esbarrou nessas proibições para um projeto recente usando o Midjourney. “Eu queria questionar o banco de dados sobre o que ele sabia sobre navios negreiros”, disse ela. “Recebi uma mensagem dizendo que o Midjourney suspenderia minha conta se eu continuasse.”

Dinkins teve problemas semelhantes com NFTs que ela criou e vendeu, mostrando como o quiabo foi trazido para a América do Norte por escravos e colonos. Ela foi censurada quando tentou usar um programa generativo, Replicate, para fazer fotos de navios negreiros. Ela acabou aprendendo a enganar os censores usando o termo “navio pirata”. A imagem que ela recebeu foi uma aproximação do que ela queria, mas também levantou questões preocupantes para a artista.

“O que essa tecnologia está fazendo com a história?” Dinkins perguntou. “Você pode ver que alguém está tentando corrigir o viés, mas ao mesmo tempo apaga um pedaço da história. Acho essas rasuras tão perigosas quanto qualquer viés, porque vamos esquecer como chegamos aqui.”

Naomi Beckwith, curadora-chefe do Museu Guggenheim, atrelou a abordagem diferenciada de Dinkins às questões de representação e tecnologia como uma das razões pelas quais a artista recebeu o primeiro prêmio de Arte e Tecnologia do museu.

“Stephanie se tornou parte de uma tradição de artistas e trabalhadores culturais que abrem brechas nessas teorias abrangentes e totalizantes sobre como as coisas funcionam”, disse Beckwith. A curadora acrescentou que sua própria paranóia inicial sobre programas de IA substituindo a criatividade humana diminuiu bastante quando ela percebeu que esses algoritmos não sabiam praticamente nada sobre a cultura negra.

Mas Dinkins não está pronta para desistir da tecnologia. Ela continua a empregá-la em seus projetos artísticos – com ceticismo. “Uma vez que o sistema pode gerar uma imagem realmente de alta fidelidade de uma mulher negra chorando ou sorrindo, podemos descansar?”